Spark 어플리케이션 개발을 하다보면 clients 에게 많은 문의를 받게되는게 아래 내용인데요.

“Spark 권장사양이 어떻게 되나요?”

질문을 받을때 마다 환경에 맞게 구성해야 합니다.., 라고 대답을 하기엔 좀 찜찜해서 이번에 아예 문서로 작성해 보았습니다.

- Nodes 란 무엇인지.

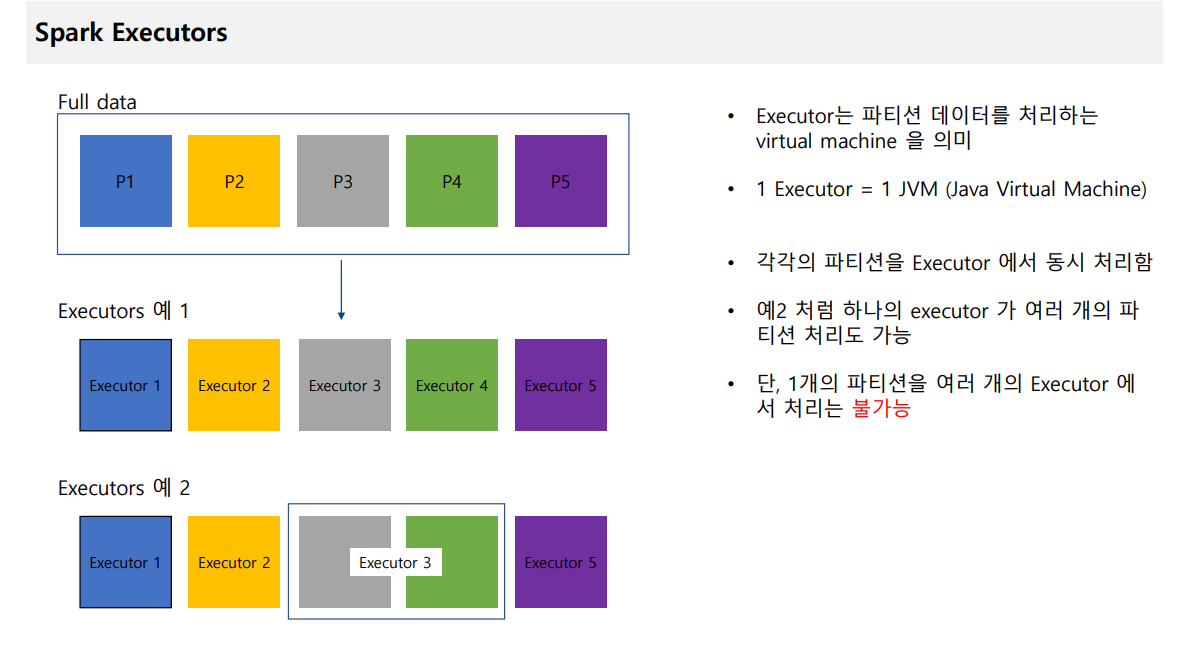

- Executors 란 무엇이며 어떻게 동작하는지.

- CPU Core 는 몇개가 적당한지

- Memory 는 어느정도가 적당한지

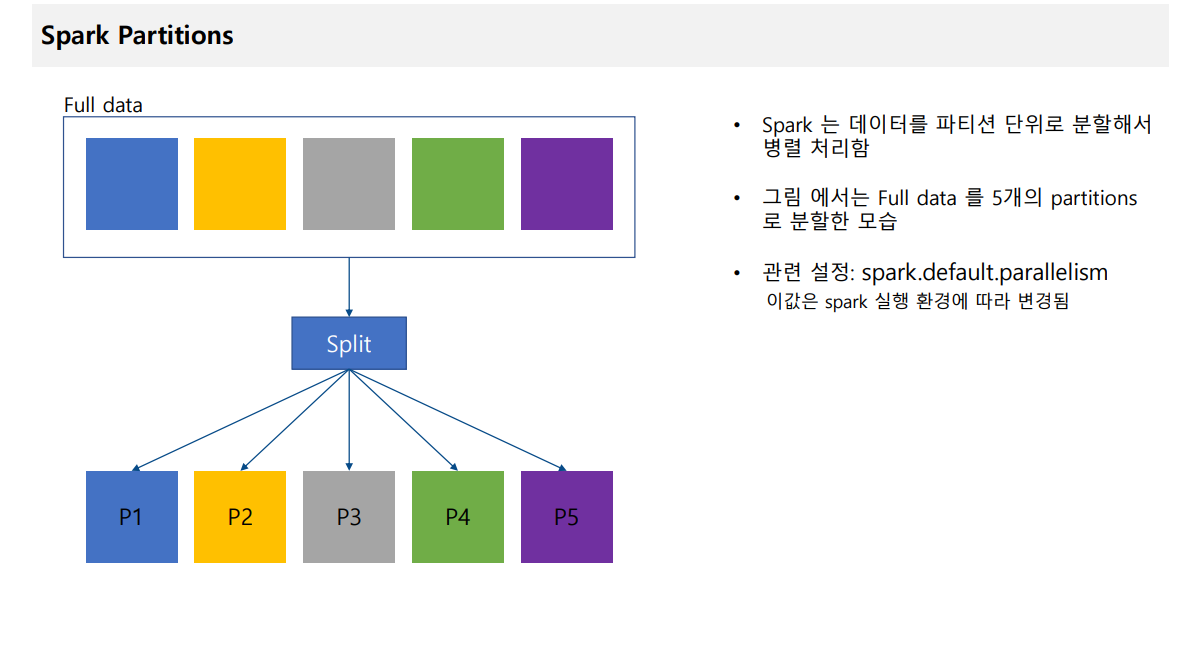

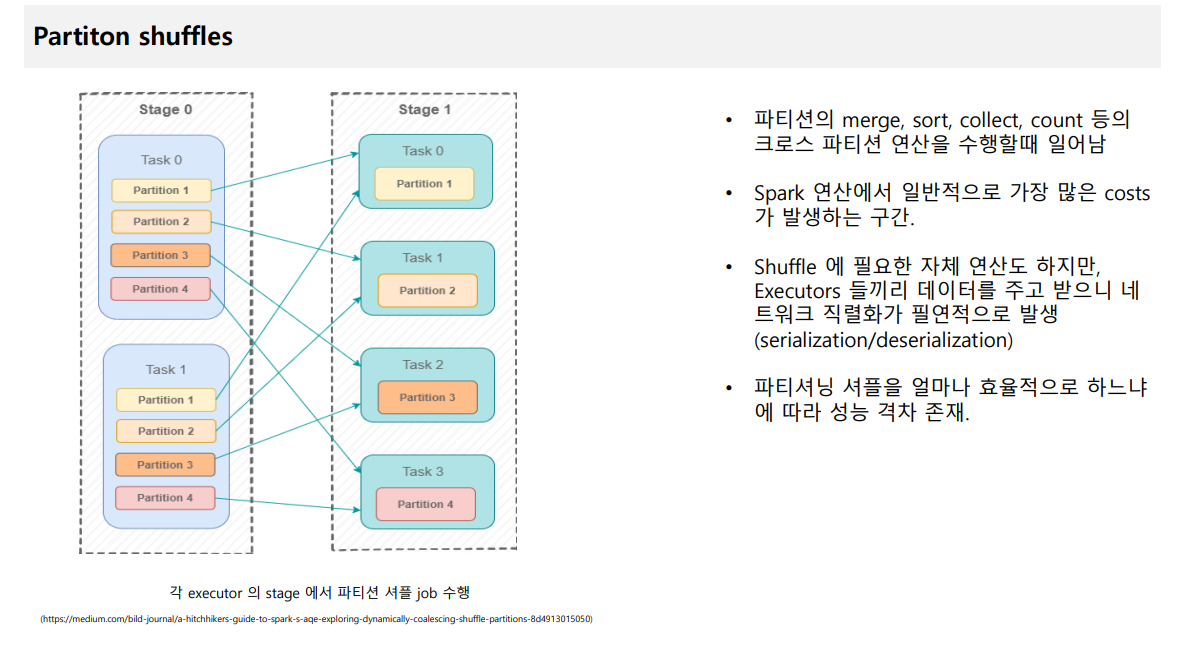

- Partition 이란 무엇이며 메커니즘이 어떻게 동작하는지

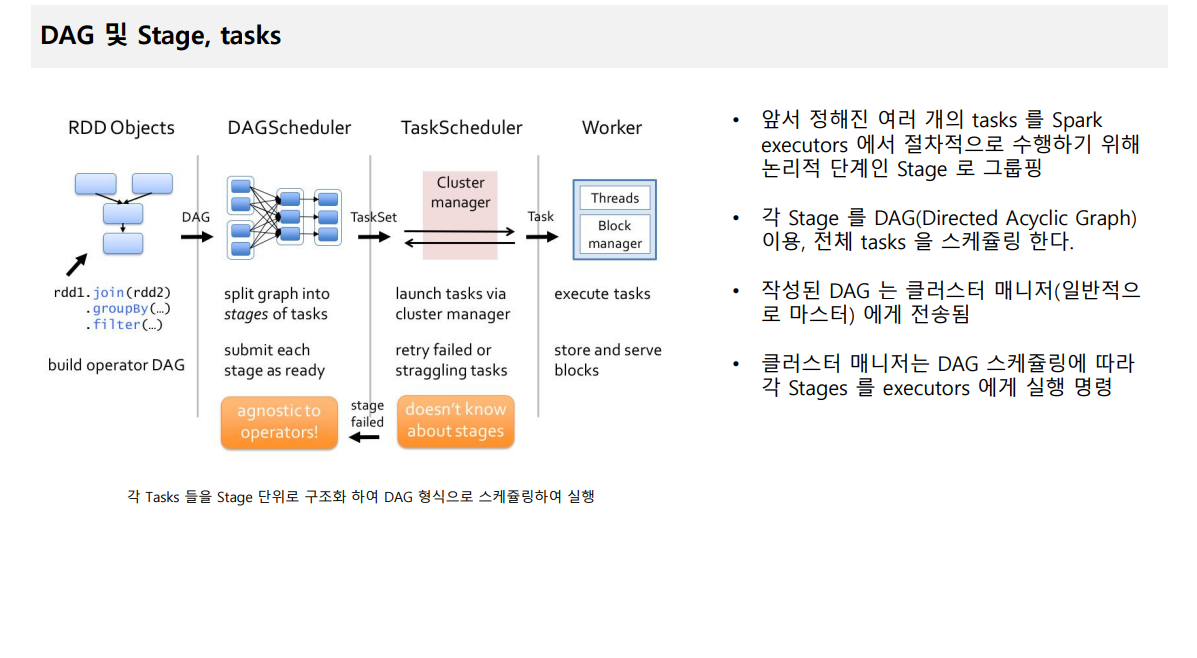

- Task 는 무엇인지

전체문서는 여기 에서 다운받을수 있습니다 :)

댓글 없음:

댓글 쓰기